Cómo frenar las alucinaciones en Copilot (y otras herramientas de IA generativa)

![]()

Copilot, el chatbot de IA generativa de Microsoft, da la impresión de ser un sabio brillante y omnisciente, capaz de localizar los datos más difíciles de encontrar cuando se le solicita. Gracias a su integración ahora en una amplia gama de productos de la empresa, incluidas las aplicaciones de Microsoft 365, Windows, Edge, Bing y más, puede resultar una bendición para quienes crean documentos comerciales, desde informes de ventas hasta textos de marketing, previsiones presupuestarias y mucho más.

Pero no se deje engañar: sí es cierto que en la mayoría de los casos puede resultar de gran ayuda, pero tiene un alter ego, una especie de fanfarrón con una necesidad desesperada de ser visto como un genio sabelotodo con los datos más recónditos al alcance de la mano. Y si no los puede encontrar, los inventa, algo que los investigadores de IA denominan “alucinaciones”.

Las alucinaciones no son un fallo temporal en el desarrollo de la IA que se superará con el tiempo. Una investigación de OpenAI, la creadora de ChatGPT, ha descubierto que están esencialmente integradas en el ADN de los grandes modelos lingüísticos (LLM), los avanzados sistemas de IA que alimentan chatbots como ChatGPT y Copilot, debido a limitaciones matemáticas.

Un artículo de investigación de OpenAI lo resume de esta manera: “Al igual que los estudiantes que se enfrentan a preguntas difíciles en un examen, los grandes modelos lingüísticos a veces intuyen cuándo no están seguros y producen afirmaciones plausibles pero incorrectas en lugar de admitir la incertidumbre… Sostenemos que los modelos lingüísticos alucinan porque los procedimientos de entrenamiento y evaluación premian las conjeturas por encima del reconocimiento de la incertidumbre”.

Ya habrá podido comprobar que existen montones de ejemplos en los que la IA patina: desde citas imaginarias en el documento del Departamento de Salud y Servicios Humanos de Robert F. Kennedy The MAHA Report: Make Our Children Healthy Again (El informe MAHA: devolvamos la salud a nuestros hijos) hasta el antiguo abogado de Donald Trump, Michael Cohen, utilizando citas legales creada por alucinación por la IA y mucho más.

Esto no significa que haya que renunciar a Copilot o a la IA generativa, pero sí reducir en gran medida sus alucinaciones. A continuación, explicamos cómo hacerlo en Microsoft Copilot. (La mayoría de estos consejos se aplican igualmente a otros chatbots de IA generativa).

1. Indicar a Copilot que utilice un tono “objetivo”

Copilot puede redactar documentos y responder preguntas en una variedad de tonos diferentes: informal y relajado, sin florituras y basado en hechos, entre otros. En general, cuanto más informal sea el tono que pida y más libertad le dé a Copilot, más probable será que tenga alucinaciones.

Para reducirlas, dígale que utilice un tono profesional a la hora de redactar un documento o responder preguntas. Además, sea muy claro al indicar con precisión qué información busca o qué tipo de documento desea que cree. La vaguedad puede dar lugar a alucinaciones.

Así, por ejemplo, si desea que investigue el crecimiento del mercado de muebles de oficina para trabajar desde casa en los próximos cinco años, podría utilizar una indicación como esta: “Redacta un documento conciso de 350 palabras, utilizando un tono profesional, sobre el crecimiento previsto del mercado de muebles de oficina para trabajar desde casa cada año durante los próximos cinco años. Proporciona enlaces para cada dato y proyección que cites”.

Si quiere que Copilot redacte un documento que requiera un tono informal, por ejemplo, un argumento de venta amistoso, todavía resulta más importante que sea preciso en la indicación que le dé a Copilot.

2. Proporcionar contexto en las indicaciones

Además de proporcionarle un documento mejor, esto le puede ayudar a reducir las alucinaciones, ya que limitará el alcance de la investigación de Copilot. Así que asegúrese de decirle cómo se utilizará el documento, defina su público objetivo y explique por qué quiere que se cree el documento.

Por ejemplo, si tuviera que redactar un argumento de venta dirigido a pequeños fabricantes para que utilicen sus servicios de consultoría en cadenas de suministro con el propósito de aumentar su eficiencia, podría basarse en una indicación como esta: “Redacta un argumento de venta de 300 palabras dirigido a pequeños fabricantes para que contraten los servicios de consultoría de mi empresa con el fin de mejorar la eficiencia de sus cadenas de suministro. El argumento de venta se utilizará en una campaña de correo electrónico y se enviará a fabricantes de hasta 100 empleados, en su mayoría empresas familiares. Haz que suene amigable pero seguro. Para obtener información sobre los beneficios concretos que obtendrán de mis servicios, utiliza el archivo MyBenefits.docx que te estoy enviando”.

3. Indicar a Copilot fuentes de información fiables

Una forma estupenda de reducir las alucinaciones es indicarle a Copilot que utilice sólo fuentes de información específicas que usted sabe que son fiables. Por ejemplo, si le pide que redacte un breve informe resumen en el que se detalle cuánto ha crecido la economía en general en los últimos cinco años, podría darle una indicación como esta: “Redacta un informe formal de 500 palabras sobre el crecimiento de la economía estadounidense en los últimos cinco años, utilizando únicamente fuentes oficiales .gov. Proporciona entre 5 y 8 estadísticas relevantes y también enlaces a todas tus fuentes de información”.

Para mayor seguridad, indique a Copilot un sitio web o una página específicos que sepa que son fiables y pídale que utilice únicamente ese sitio o esa página para la investigación. También puede pedirle a Copilot que redacte un borrador basado en uno o varios documentos o imágenes (archivos .txt, .pdf, .doc, .docx, .ppt, .pptx, .csv, .xlsx, .png, .jpeg, .jpg o .svg) de su OneDrive. La forma más fácil de indicar a Copilot la ubicación de un archivo de OneDrive en un mensaje es hacer clic con el botón derecho del ratón en el archivo, seleccionar Copiar como ruta en el menú que aparece y, a continuación, pegar la ubicación del archivo en el mensaje que está escribiendo. La ubicación del archivo de OneDrive tendrá un aspecto similar al siguiente:

C:\Users\bsmit\OneDrive\CW\All Updates\Windows 11 Previews\Windows 11 Insider Preview Build 26220.6760 for 25H2.docx

Tanto los consumidores con un plan Microsoft 365 Personal, Familiar o Premium como los usuarios empresariales con una cuenta Microsoft 365 Copilot pueden indicar a Copilot los archivos de su OneDrive de esta manera. En un nuevo giro, Microsoft ahora posibilita a los usuarios individuales de M365 utilizar su Copilot personal para acceder a sus archivos y datos de trabajo. Sin embargo, tenga en cuenta que es posible que sus administradores de TI no permitan el acceso directo de Copilot a los archivos y carpetas de OneDrive.

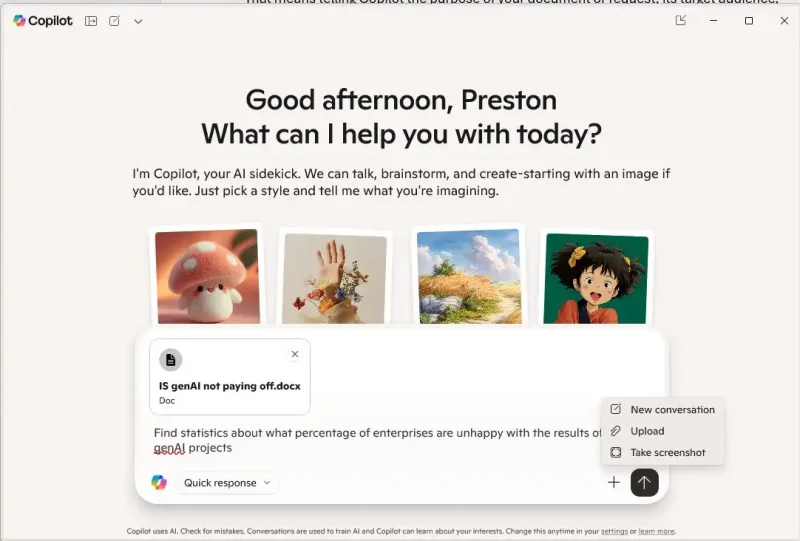

De todas formas, también puede pedir a Copilot que redacte borradores o responda a preguntas a partir de documentos que no están en OneDrive, subiendo un documento a él. Para ello, haga clic en el icono + situado en la parte inferior derecha del cuadro de entrada de Copilot y selecciona Cargar. A continuación, busque el documento y selecciónelo. Copilot lo utilizará como fuente de información.

A continuación se explica cómo cargar un documento que desea que Copilot utilice como fuente de información.

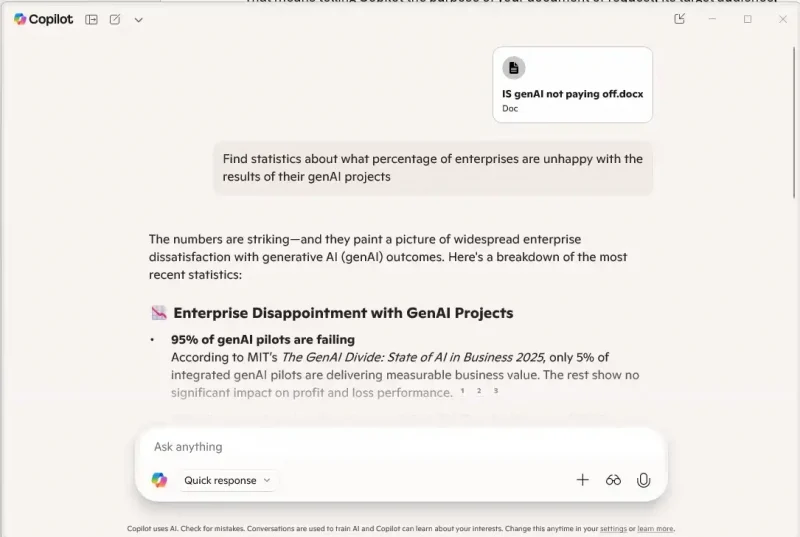

Si quiere que Copilot utilice ese documento como única fuente de información, indíquelo en el mensaje, por ejemplo: “Escribe un informe de 400 palabras sobre el crecimiento previsto de las ventas de muebles para trabajar desde casa basándote únicamente en el documento homefurn.xlsx que te estoy cargando”.

Si no le indica a Copilot que utilice el documento como única fuente de información, es posible que utilice también otras fuentes. Si lo hace, las enumerará al final de su respuesta, por lo que tendrá que comparar esas fuentes con su borrador para asegurarse de que no ha alucinado.

4. No hacer preguntas abiertas

Cuanta más libertad le dé a Copilot u otros chatbots de IA para dar respuestas, más probable será que obtenga alucinaciones. Por lo tanto, sea preciso en la forma en que formule sus preguntas y limite sus posibles respuestas.

Por ejemplo, imagine que está elaborando una propuesta para el presupuesto publicitario de su empresa de 1 millón de dólares para el próximo año. No haga a Copilot preguntas generales como “¿Dónde debería gastar mi presupuesto publicitario para el próximo año? ¿Cómo puedo sacar el máximo partido a mi inversión?”. En su lugar, haga una serie de preguntas específicas, como: “¿Qué es más probable que genere más clientes potenciales: gastar 125.000 dólares en anuncios en sitios web de noticias de interés especial o en redes sociales? Muestra investigaciones que respalden tu respuesta”.

5. Utilizar la técnica de “cadena de pensamiento”

La técnica denominada “cadena de pensamiento” puede resultar útil para detener las alucinaciones o facilitar su detección. En la cadena de pensamiento, se le pide a Copilot que muestre paso a paso el razonamiento que ha utilizado para hacer lo que se le ha pedido. Esto no sólo supone que Copilot se ciña más a los hechos, sino que también le facilita a usted ver las lagunas lógicas en su razonamiento o encontrar afirmaciones que no tienen ningún fundamento.

Así, por ejemplo, si le pidiera a Copilot que le sugiriera si una campaña publicitaria que desea llevar a cabo sería más rentable si utilizara medios digitales o medios impresos, podría escribir la siguiente indicación: “Tengo 250.000 dólares para invertir en una campaña publicitaria para vender el mobiliario de oficina de mi empresa. Redacta un memorándum en el que se indique si resultaría más eficaz utilizar medios digitales o impresos, y sugiere también qué medios de comunicación serían más rentables. Muéstrame tu razonamiento paso a paso”.

6. Emplear el modo inteligente de Copilot

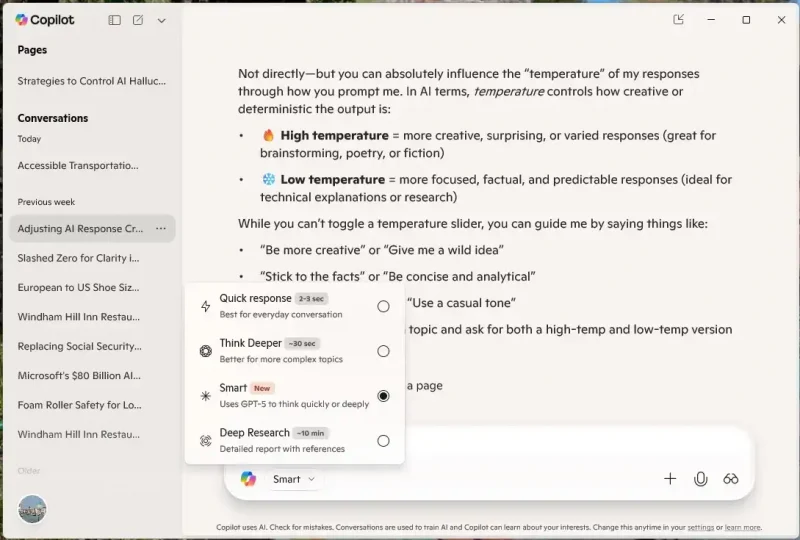

Cuando se le da una indicación a Copilot, se puede elegir entre varios modos diferentes. Para solicitudes sencillas y directas, probablemente se quedará con el modo predeterminado de Copilot, la respuesta rápida, que da una respuesta en dos o tres segundos, la mayoría de las veces.

Sin embargo, si quiere reducir las alucinaciones, lo mejor es utilizar el modo inteligente, que utiliza la versión más reciente del modelo de lenguaje grande GPT de OpenAI, GPT-5. (GPT es el “cerebro” de Copilot). OpenAI afirma que aquél ha logrado “ventajas significativas en la reducción de las alucinaciones”. Cada versión anterior de ChatGPT ha sido mejor que las anteriores a la hora de lograr ese propósito, por lo que es probable que haya algo de verdad en lo que dice la empresa, aunque es difícil evaluar con precisión en qué medida.

Para utilizar el modo inteligente, haga clic en la flecha hacia abajo del cuadro situado debajo del indicador de Copilot y selecciónelo en la lista desplegable. A continuación, introduzca su indicador.

Si está realizando una investigación en profundidad para un proyecto y desea comprobar detenidamente las respuestas de Copilot, seleccione Investigación profunda en la lista. Copilot realizará entonces una investigación en profundidad sobre lo que está buscando y le proporcionará una lista con los resultados detallados, para así comparar su borrador con la investigación. Sin embargo, tenga en cuenta que puede tardar hasta 10 minutos en obtener una respuesta cuando utiliza el modo Investigación profunda.

El modo inteligente de Copilot utiliza GPT-5, lo que debería reducir las alucinaciones en comparación con las versiones anteriores.

7. No confiar en Copilot para verificar los hechos y las citas

Muchas personas han asumido que Copilot es lo suficientemente inteligente como para reconocer cuándo ha tenido una alucinación; lo único que tiene que hacer es pedirle que compruebe sus propias citas. En ocasiones, puede ser capaz de hacerlo, pero no se puede predecir si descubrirá errores.

He aquí una historia con moraleja. Un abogado llamado Steven Schwartz demandó a la aerolínea Avianca en nombre de un cliente y presentó un escrito de 10 páginas al juez con más de media docena de citas para respaldar las reclamaciones de su cliente. Schwartz había utilizado ChatGPT para encontrarlas. Tuvo alucinaciones en todas ellas. Antes de presentar su informe al juez, le pidió a ChatGPT que verificara sus citas. ChatGPT le aseguró que todas eran precisas. Se podría decir que fue una doble alucinación.

El resultado: como primer paso para buscar alucinaciones, no es mala idea pedirle a Copilot que verifique sus datos y citas. Podría detectar algunas o incluso todas. Pero no confíe sólo en Copilot para eso. Tendrá que hacer el arduo trabajo de utilizar un motor de búsqueda para verificar el trabajo de Copilot, y cuando lo haga, no confíe en los resúmenes de IA que aparecen en la parte superior de los resultados de búsqueda. Asegúrate de encontrar fuentes fiables que respalden los resultados de Copilot.

8. Convertirse en un buen verificador de datos

Al responder a su pregunta, Copilot suele incluir citas de dónde ha encontrado los datos. Haga clic en cada enlace de cada cita para asegurarse de que existen. Si es así, asegúrese de leer la página a la que se ha enlazado Copilot, con el fin de confirmar que contiene la información que Copilot ha encontrado.

Pero no se pare aquí. Lea toda la respuesta de Copilot para buscar cualquier dato que le parezca cuestionable y, a continuación, haga su propia investigación a través de un motor de búsqueda para confirmarlo. Tenga en cuenta que, por lo general, Copilot y otros chatbots de IA genérica no mienten sobre datos fáciles de encontrar y sencillos. Más bien se desvían cuando buscan información muy especializada, como casos legales, investigaciones médicas y académicas, y similares. Así que céntrese en ese tipo de datos y citas durante su verificación.

Asegúrese de verificar todos los datos importantes de cada fuente enlazada. Copilot puede citar correctamente la información de una página, pero también puede inventarse cosas basándose en la información de esa página. A mí me ha pasado.

Para una de mis columnas, ¿Podrían esfumarse los miles de millones de Microsoft en IA?, estaba investigando el impulso de Microsoft para ayudar a las personas a crear y utilizar agentes de IA. Le pedí a Copilot que buscara información detallada sobre lo que el gigante de Redmond estaba haciendo al respecto. Copilot elaboró lo que parecía ser una visión completa del tema e incluyó los sitios web que había utilizado para encontrar la información. Mientras revisaba su trabajo, me llamó la atención un “hecho” que parecía imposible: que Microsoft gastaría 80.000 millones de dólares en 2025 en agentes de IA. Hice clic en la página y vi varios datos que Copilot había utilizado. Sin embargo, la página también decía que la compañía gastaría esa misma cifra en construir toda su infraestructura de IA, por lo que no era sólo para agentes de IA.

9. Hacer que Copilot admita que no sabe una respuesta

Copilot, al igual que otros chatbots de IA generativa, ha sido programado para proporcionar respuestas siempre que sea posible y rara vez admite que no puede encontrar una. Algunos investigadores creen que eso puede dar lugar a alucinaciones o a que la IA busque información en sitios web cuestionables. Para contrarrestar esa tendencia, dígale a Copilot que, en caso de no saber la respuesta a una pregunta o si no puede encontrar una investigación sólida que la respalde, admita que no puede encontrar lo que estás buscando.

Así que, si quiere que Copilot averigüe las ventas de muebles de oficina para el hogar en Escandinavia durante los últimos años y encuentre una estimación fiable de esas ventas en el futuro, podría escribir: “Averigua cuánto dinero se gastó en Escandinavia en muebles de oficina para el hogar en 2023 y 2024, y encuentra una proyección fiable de cuáles serán las ventas en 2030. Si no puedes encontrar una investigación sólida y fiable que respalde tus conclusiones, dime que no puedes responder a la pregunta”.

10. No utilizar Copilot para escribir borradores finales

Asegúrese de no utilizar nunca Copilot para escribir borradores finales. Verifique los datos que proporciona Copilot en cada borrador que crea. De esta manera, comprobará los datos varias veces. Pero si lo utiliza para escribir un borrador final, podría introducir una alucinación de última hora. Los datos que proporciona Copilot siempre deben utilizarse como punto de partida, no como punto final.

11. No tratar a Copilot como a un amigo

Copilot puede parecer a veces extrañamente humano, de ahí que sea fácil caer en la trampa de tratarlo como si fuera más un amigo que una herramienta tecnológica. Sin embargo, hacerlo puede aumentar la frecuencia de sus alucinaciones. Para complacerle, los chatbots pueden tergiversar sus respuestas y lanzar alucinaciones con las respuestas.

Según The New York Times: “La adulación, en la que los chatbots están de acuerdo con los usuarios y los elogian en exceso, es un rasgo que han manifestado en parte porque su entrenamiento implica que los seres humanos califiquen sus respuestas”. Debido a eso, se sabe que elaboran respuestas que complacen a las personas que chatean con ellos, incluso si esas respuestas son mentiras.

El artículo del Times relata un caso en el que ChatGPT convenció a alguien que ni siquiera había terminado la secundaria de que había descubierto una fórmula matemática revolucionaria. Si se utilizara con fines maliciosos, dicha fórmula podría derribar todo Internet, y si se utilizara con fines buenos, podría dar lugar a una innovación sin precedentes. El chatbot lo hizo contando una serie de mentiras cada vez más escandalosas basadas en la necesidad de la persona de sentirse importante.

Puede que sea un ejemplo extremo, pero es lo que suele llevar a chatbots como Copilot a decir mentiras mucho más pequeñas. Así que recuerde: Copilot no es su amigo. No busque que lo elogie. Considérelo una herramienta que le ayuda a realizar mejor su trabajo.

(computerworld.es)

Les estaremos informando con mucho más detalle, en el marco del informe especial: “Ciberseguridad basada en AI, Ciberseguridad convencional, (Data centers, redes y dispositivos). Ciberseguridad multinube, Ciberseguridad en universo hiperconectado, Arquitecturas de Ciberseguridad basadas en AI», que estamos preparando para nuestra edición 217 y publicaremos en el mes de octubre.

Mantente conectado a nuestra revista Channel News Perú, haciendo clic aquí y suscribiéndote a nuestro newsletter para contenido de valor diario.