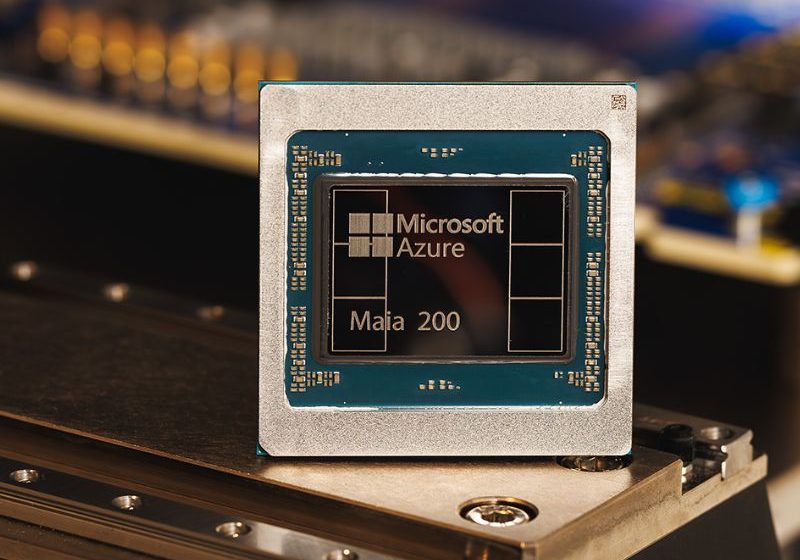

Microsoft presentó ayer el chip acelerador Maia 200, que representa un importante movimiento del proveedor en su estrategia de infraestructura de IA, siendo su primera plataforma de silicio y sistemas optimizada específicamente para la inferencia de modelos de lenguaje de gran escala (LLM) y razonamiento moderno. Este chip ha sido diseñado con el objetivo de transformar […]Leer más

Tags :inferencia

Durante los últimos años, la conversación sobre inteligencia artificial estuvo dominada por la carrera por entrenar modelos cada vez más grandes, complejos y costosos. Sin embargo, de cara a 2026, el eje del debate tecnológico comienza a desplazarse: el verdadero desafío ya no está en cómo entrenar modelos de IA, sino en cómo operarlos de forma eficiente, […]Leer más

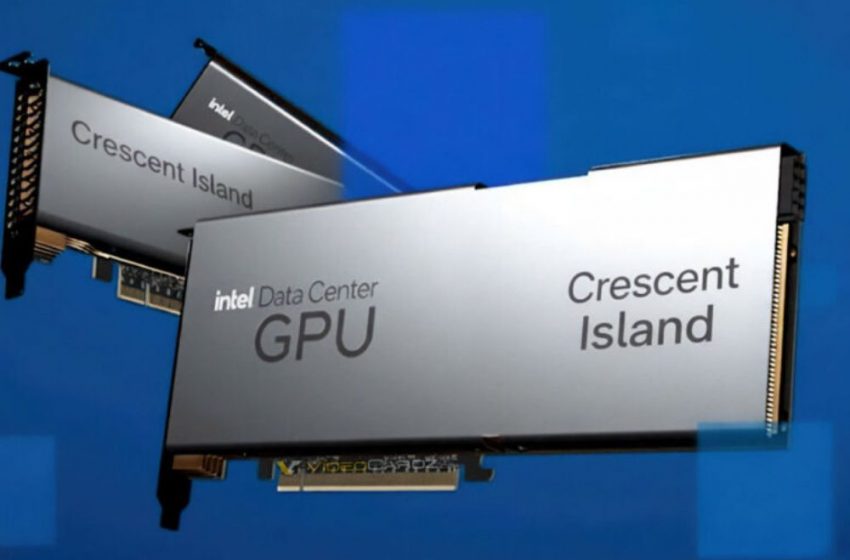

En el OCP Global Summit 2025, Intel presentó Crescent Island, una GPU especialmente diseñada para centros de datos que responde a la demanda global de cargas de trabajo de inferencia en inteligencia artificial (IA). Este nuevo acelerador prioriza la eficiencia energética, el alto rendimiento y una gran capacidad de memoria, posicionando a la compañía como un proveedor integral de soluciones […]Leer más

Red Hat lanza la comunidad llm-d para impulsar la inferencia distribuida de IA generativa a escala

Red Hat ha anunciado el lanzamiento de llm-d, una nueva iniciativa de código abierto para la inferencia de inteligencia artificial generativa a gran escala. Esta plataforma nace con el objetivo de que la IA generativa en producción alcance la misma ubicuidad que logró Linux en el ámbito de la infraestructura tecnológica. Creado en colaboración con […]Leer más

Según Canalys, el gasto mundial en infraestructura como servicio y plataforma como servicio (IaaS y PaaS) alcanzó los 90.900 millones de dólares en 2025, lo que supone un aumento del 21% con respecto al año anterior. Bajo mi punto de vista, el debe de este aumento hay que ponerlo en la migración de las cargas de trabajo […]Leer más

Los trazos generales sobre cómo construir un gran clúster de entrenamiento de IA están bastante definidos: junta tantas GPU como sea posible, llénalas con redes rápidas e incorpora tantos datos como sea posible. Pero, a medida que la IA se prepara para entrar en su era de inferencia, cómo debería ser un centro de datos […]Leer más

NetApp e Intel se alían y anuncian una solución para impulsar la adopción de la inferencia de inteligencia artificial IA). Esta solución conjunta se llama NetApp AIPod Mini y ofrece procesadores Intel Xeon 6 e Intel Advanced Matrix Extensions (AMX), almacenamiento all-flash de NetApp, gestión avanzada de datos e integración con Kubernetes. Construida sobre un marco abierto impulsado por Open Platform […]Leer más